字数 913,阅读大约需 5 分钟

通义千问32B媲美DeepSeekR1

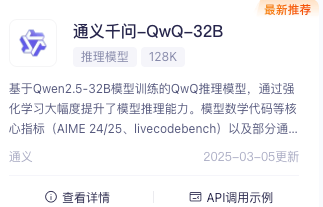

基于Qwen2.5-32B模型训练的QwQ推理模型,通过强化学习大幅度提升了模型推理能力。模型数学代码等核心指标(AIME 24/25、livecodebench)以及部分通用指标(IFEval、LiveBench等)达到DeepSeek-R1 满血版水平,各指标均显著超过同样基于 Qwen2.5-32B 的 DeepSeek-R1-Distill-Qwen-32B。

阿里云百炼体验Qwen2.5-32B

计费

限时免费

额度

免费额度:1000000/1000000

最近到期免费额度:1000000/1000000

最近到期时间:2025-09-01

平台

https://bailian.console.aliyun.com/?spm=5176.29597918.J_SEsSjsNv72yRuRFS2VknO.2.69a07ca0R4kMta#/model-market/detail/qwq-32b[]()

使用方案

• 使用SDK调用时需配置的base_url:https://dashscope.aliyuncs.com/compatible-mode/v1

• 使用HTTP方式调用时需配置的endpoint:POST https://dashscope.aliyuncs.com/compatible-mode/v1/chat/completions

• 模型名称:qwq-32b

HuggingFace介绍的qwen2.5-32B

https://huggingface.co/Qwen/Qwen2.5-32B[]()

模型能力提升方面

知识和能力提升:该模型在编码和数学领域拥有显著更多的知识,并且在这些领域的编码和数学能力得到了极大提升,这得益于其在这些特定领域有专门的专家模型。

指令遵循和文本生成能力提升:模型在遵循指令方面有显著改进,能够生成较长的文本(超过8k个标记),理解结构化数据(例如表格),并且能够生成结构化输出,尤其是JSON格式。这使得模型在处理复杂指令和生成复杂文本方面表现更好。

对系统提示的适应性增强:模型对系统提示的多样性更加有韧性,能够更好地实施角色扮演和为聊天机器人设置条件。这意味着模型可以根据不同的提示和场景灵活调整自己的行为和输出。

长文本支持能力:模型支持长文本上下文,最长可达128k个标记,并且能够生成最多8k个标记的文本。这使得模型能够处理和生成更长、更复杂的文本内容。

多语言支持方面

该模型支持超过29种语言,包括中文、英文、法文、西班牙文、葡萄牙文、德文、意大利文、俄文、日文、韩文、越南文、泰文、阿拉伯文等。这表明模型具有很强的跨语言能力,能够理解和生成多种语言的文本。

模型基础信息方面

模型类型:这是一个因果语言模型,它基于因果关系来生成文本,通常用于自然语言处理任务。

训练阶段:目前处于预训练阶段,即模型正在通过大量的数据进行初步训练,以学习语言的模式和规律。

架构:模型采用了基于transformers的架构,并且包含了RoPE(旋转位置嵌入)、SwiGLU(一种激活函数)、RMSNorm(均方根归一化)和注意力QKV偏置等技术。这些技术有助于模型更好地处理和理解语言数据。

参数数量:模型总共有325亿个参数,其中非嵌入参数有310亿个。参数数量越多,模型的表达能力和学习能力通常越强。

层数:模型有64层,层数较多的模型通常能够学习到更复杂的特征和模式。

注意力头数量:在GQA(分组查询注意力)中,Q(查询)有40个注意力头,KV(键值)有8个注意力头。注意力头数量影响模型对不同信息的关注程度和处理能力。

上下文长度:模型能够处理的上下文长度为131072个标记,这决定了模型在一次处理中能够考虑的信息量大小。

评论区