摘要:使用ollama在本地使用deepseek-r1等开源大模型

Ollama 是一个开源的大型语言模型服务工具,旨在帮助用户快速在本地运行大模型。通过简单的安装指令,用户可以通过一条命令轻松启动和运行开源的大型语言模型。 它提供了一个简洁易用的命令行界面和服务器,专为构建大型语言模型应用而设计。用户可以轻松下载、运行和管理各种开源 LLM。与传统 LLM 需要复杂配置和强大硬件不同,Ollama 能够让用户在消费级的 PC 上体验 LLM 的强大功能。

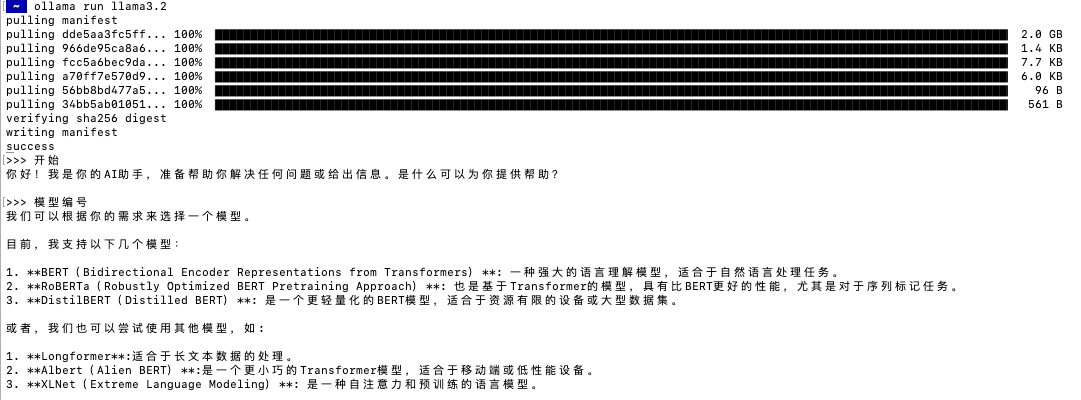

Run Llama 3.3, DeepSeek-R1, Phi-4, Mistral, Gemma 2, and other models, locally.

部署

Meta's Llama 3.2 goes small with 1B and 3B models.

~ ollama list ok 09:34:05

NAME ID SIZE MODIFIED

~ ollama list ok 09:34:08

NAME ID SIZE MODIFIED

llama3.2:latest a80c4f17acd5 2.0 GB 3 minutes ago

~ ok 09:38:10

~ ok 09:38:11

~ ollama ps ok 09:38:11

NAME ID SIZE PROCESSOR UNTIL

llama3.2:latest a80c4f17acd5 4.0 GB 100% GPU 4 minutes from now

~ ok 09:38:12

仓库

命令

ollama 命令汇总

Last login: Sun Jan 26 09:28:46 on ttys000

~ ollama ok 0

Usage:

ollama [flags]

ollama [command]

Available Commands:

serve Start ollama

create Create a model from a Modelfile

show Show information for a model

run Run a model

stop Stop a running model

pull Pull a model from a registry

push Push a model to a registry

list List models

ps List running models

cp Copy a model

rm Remove a model

help Help about any command

Flags:

-h, --help help for ollama

-v, --version Show version information

Use "ollama [command] --help" for more information about a command.终止 Ollama 模型推理服务,可以使用 /bye

Ollama 进程会一直运行,如果需要终止 Ollama 所有相关进程,可以使用以下命令:

终止 Ollama 模型推理服务,可以使用 /bye容器

version: "3"

services:

ollama:

container_name: ollama

image: ollama/ollama:latest

restart: always

ports:

- "11434:11434"

volumes:

- /data/ollama:/root/.ollama

environment:

OLLAMA_ORIGINS: "*"

OLLAMA_HOST: "0.0.0.0"

API调用

ollama show --help 可以看到本地访问地址为: http://localhost:11434

generate 和 chat

generate 和 chat 的区别在于,generate 是一次性生成的数据。chat 可以附加历史记录,多轮对话

通过 “stream”: false 参数一次性返回generate

~ ollama ps ok 14:47:42

NAME ID SIZE PROCESSOR UNTIL

deepseek-r1:1.5b a42b25d8c10a 2.1 GB 100% GPU 4 minutes from now

~ curl http://localhost:11434/api/generate -d '{ ok 14:47:26

"model": "deepseek-r1:1.5b",

"prompt":"介绍一下React,20字以内"

}'

chat

~ curl http://localhost:11434/api/chat -d '{ INT 14:51:45

"model": "deepseek-r1:1.5b",

"messages": [

{ "role": "user", "content": "介绍一下React,20字以内" }

]

}'

评论区