总结

关于埃隆·马斯克(Elon Musk)的XAI公司在孟菲斯(Memphis)启动了世界上最大的人工智能(AI)训练集群的概述和要点。以下是对这些要点的解释:

XAI的启动:埃隆·马斯克宣布在孟菲斯建立了世界上最强大的AI训练集群。

水资源消耗:该集群每天消耗100万加仑的水,引起了当地居民的担忧。

能源需求:它需要150兆瓦的电力,这给当地资源带来了压力,并引发了环境问题。

冷却系统:由于GPU密度高,对先进冷却技术的需求增加了。

环境抗议:当地活动人士反对数据中心对水资源可用性和环境可持续性的影响。

数据中心的演变:数据中心从CPU向GPU的转变带来了重大的基础设施挑战。

创新解决方案:公司正在探索各种冷却和电力解决方案,以减轻环境影响。

关键洞察:

AI基础设施挑战:快速转向以GPU为中心的数据中心需要对冷却和电力系统进行重大升级,这突显了创新的必要性。

水资源使用问题:AI数据中心的高水资源消耗加剧了当地的干旱状况,引发了伦理和可持续性问题。

能源效率需求:随着功率密度的增加,优化能源供应和冷却效率变得至关重要,以防止操作失败。

环境影响:社区对AI数据中心的反对表明了对可持续技术实践日益增长的意识和需求。

预制趋势:向预制数据中心组件的转变可以提高建设速度和效率,解决紧急的容量需求。

技术演变:升级旧数据中心以适应像NVIDIA这样的新芯片需要战略规划和基础设施投资。

AI训练的未来:冷却和电力技术的进步将塑造AI模型训练的未来,平衡效率与环境影响。

原文

00:00

2024年7月22号凌晨创始人Elon Musk在推特上正式宣布在凌晨4点20分正式启动了世界上最强的AI训练集群这个训练集群建设在美国田纳西州孟非斯市集合了10万个夜冷的H100芯片然而这在当地却引发了居民们的抗议和不满Memphis City Council members frustrated about howXAI will impact power, water and gas in Memphis

00:28

这样巨大的AI训练集群每天会消耗100万加仑的水和150兆瓦的电力因此也是引发了当地环保人士的担心和抗议随着万卡集群甚至10万卡集群成为科技巨头们训练AI大模型的标配这样的巨型数据中心到底意味着什么消耗电力好理解那为什么会消耗如此多的水呢冷却系统与供电系统等关键基础设施是如何运作的

00:55

目前数据中心的主计算芯片开始从CPU转向GPU这会带来如何的变革呢那可能大家对CPU GPU这类计算芯片了解比较多但是很少会关注配套的基础设施但事实上它们就像冰山藏在水下的部分一样不仅是整个数据中心的支柱还是至关重要的安全枢纽

01:17

大家好欢迎收看硅谷101我是陈倩那今天我们就来揭秘一下万卡集群的数据中心到底是如何运作的也非常荣幸邀请到了专注于数据中心基础设施的公司维地技术的多位专家来一起聊聊AI爆发给数据中心的基础设施带来的挑战和机遇

01:41

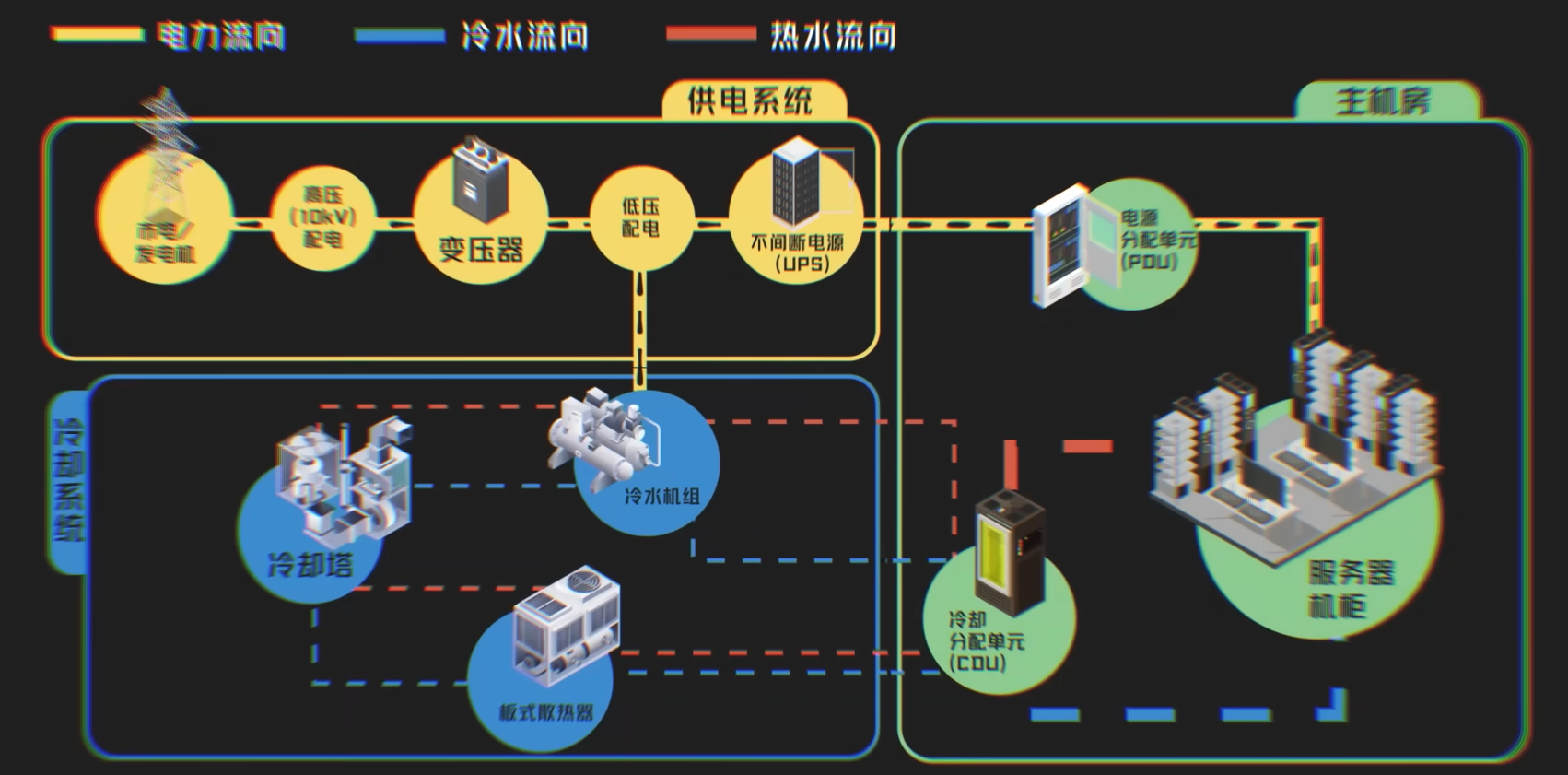

首先我们先来简单了解一下数据中心的组成结构从物理结构上来看数据中心会划分成三个系统主机房供电系统和冷却系统如果咱们把数据中心类比成一支军队你看这主机房陈列的一排排机柜像不像前线征战的士兵他们承担着整个数据中心的核心功能运算而冷却与供电系统则是军队后方的保障机构

02:08

冷却系统负责保障士兵的健康与安全供电系统负责粮草的运送与分配此外还有综合管理系统来维护兵器等等他们就像数据中心的兵部尚书虽然不在一线征战却是起到了关键的作用

02:23

如今一些数据中心开始由通用计算转向专用计算其中以AI为主的数据中心被称为制算数据中心主力芯片从CPU变成了GPU那么这也将对所有基础设施带来巨大的挑战

02:38

因为传统的CPU其实过去十多年的时间一直在采用的X86的结构所以它的CPU的功耗包括服务器的功耗都相对比较标准和恒定所以我们在过去的近十多年的时间看到数据中心的平均的机柜的功率密度大概一直在三到五千瓦左右

02:59

但是現在隨著GPU的採用AI模型的推理和訓練需要集中大量的GPU來進行並行的浮點運算需要通過集群的方式通過軟件互聯通信來

03:15

在非常小的空间里面集中大量的GPU所以这个使得GPU的服务器包括单机柜的功率密度会迅速的提高所以我们也看到机柜的功率密度从过去的5000瓦现在迅速的提升到了10千瓦20千瓦40千瓦甚至80千瓦100千瓦以上

03:34

至算机柜功率密度的提升对基础设施来说我觉得主要有四大方面的挑战首先是功率密度提升之后给散热能力带来的挑战第二个方面是给高效的能源供应带来的挑战第三个是占地面积第四是快速的部署

03:52

所以GPU芯片的迅速更新迭代给数据中心配套设施带来了这四大挑战那么如何应对这四个问题呢我们先来看一下冷却系统为什么它会如此的耗水

04:07

电子器件运行的时候会产生热量而芯片对热量尤其敏感如果过热轻则触发芯片的自我保护机制降低运行频率重则导致服务器故障业务中断甚至烧毁硬件随着数据中心的功率密度越来越高这时候如果冷却系统发生故障留给维护人员的反应时间可能就只有一两分钟了但是如果单机会到了10千万按照我们过去的仿真经验可能很快一两分钟

04:35

就能到30多度甚至40度那就当机了因此呢芯片算力的升级也直接带来了对数据中心冷却系统的升级需求我们在AI电力争夺战那些视频当中也讲过随着功率密度的提升那么厂商们开始转向夜冷办案而恰恰是这个夜冷导致了不少环保人士的抵制

04:57

除了开头说的XAI训练集群之外2023年乌拉圭民众也联合抗疫谷歌建设数据中心还有新墨西哥州的农民抗疫Manta数据中心的迁入大家抵制的原因之一就是这些数据中心耗水太多甚至加剧了当地的干旱情况那为什么夜冷会消耗如此多的水呢?

05:20

在回答这个问题前我们需要简单的科普一下冷却系统的结构目前冷却系统主要分为两个大类风冷与夜冷那么我们先来聊一聊风冷如果你进入过数学中心那第一感觉就应该是太吵了

05:39

这个噪音就来自机柜中用于给芯片降温的风扇风扇的作用是将芯片的热量散发到空气中但是如果热量全部都堆积在空气中也会降低散热效果所以还需要空调对空气降温空调也分为很多种在这里就不一一的举例了想要意见的是空气的热交换效率较低在功率密度不断提升的情况下必须采用效率更高的散热介质那就是液体

06:11

液冷散热的原理就是通过水的蒸发前热来带走芯片的热量液冷散热也分为很多种目前全球主流的两类是冷板液冷和静默液冷当然在国内还有一种是喷零液冷技术喷零它其实也是一个比较创新的技术当然这个创新的技术目前还是受到了一定的限制所以不是很多

06:32

冷板液冷是让冷板与芯片紧密贴合让芯片热量传导至冷板中的冷却液并且将冷却液中的热量运输至后端冷却而静默液冷是将整个主板都静默在特定的液体当中但对于目前主流的GPU设备来说静默液冷却不太适用因为所有GPU它都是还是按照冷板液冷这种规格来开发的所以不太适配静默

06:57

冷却系统会分为一次测和二次测一次测是将整体热量散走并与二次测的冷却分发单元cooling distribution unit简称CDU来交换热量通常提到的夜冷散热都是指二次测由CDU将冷水分配到各个机柜中而当前的夜冷散热系统一次测大部分也是水冷方式最终在室外通过水的显热交换和前热交换带走全部热量

07:22

显热交换是水在加热或者冷却过程当中会吸收或释放的热量水的状态不变而浅热交换就是水在相变过程中如蒸发、凝结、融化、凝固的时候吸收或释放的热量而温度保持不变就像咱们天气热的时候如果给房间去泼一盆冷水水温慢慢升高这就是显热交换同时水会慢慢蒸发这就是浅热交换两种交换共同进行使得水盆上方的空气温度降低

07:50

前面我们说到环保人士抵制AI数据中心就是因为万卡集群的AI数据中心浪费的水实在是太多了这其实就回到那个规模效应了如果说咱们只是建一两个数据中心比如说就是像20兆瓦或者甚至到100兆瓦都没事但是如果进一步扩大那那个耗水量是非常非常巨大的

08:13

那这会儿的话可能会对当地的地下水资源有一定的影响可以肯定一定会存在数据中心和人抢水的这个问题那你可能想问啊就算水蒸发了那不是还会变成水降下来吗为什么会被称为浪费呢我们分两个方面来说啊

08:31

首先水蒸发之后变成云飘到哪儿降落就不好说了数据中心就像个抽水机把当地的水抽走之后送到了其他地方对于原本降雨量低的地区加剧了干旱情况其次数据中心对水的质量要求也不低但高质量的水蒸发之后如果降落在污染或者海面这些水就很难再利用了

08:53

同时使用高质量的水也意味着数据中心要和居民去抢水甚至可能会造成居民水不够的情况那问题又来了为什么一定要用高质量的水呢那水如果蒸发它就会跟制冷设备的一些部件会有接触

09:10

然后水可能就是水物不管是水滴还是水物它到制冷设备上面那如果水质不太好比如说酸碱度不太好偏酸偏碱都可能会导致腐蚀那如果钙美离子的含量比较多就像咱们家里烧开水一样那可能水垢就会附着在表面上那一旦水垢附着在换热设备的表面带来的影响就是换热设备的效率会下降

09:33

本来我是200千瓦的散热量但是因为水过问题可能会导致它衰减到80%甚至更低那带来的就是冷量可能不够就是这一类的问题

09:43

有报道称每个数据中心平均每天要消耗100万到500万加仑的水比如开头提到的XAI万卡集群每天消耗100万加仑的水可供3000多户家庭使用一天而GBT-3在训练期间消耗了700万吨水后续的推理阶段每回答20个问题就相当于倒掉了一瓶500毫升的矿泉水

10:06

NPGA的一份名为数据中心用水调查报告就显示数据中心耗水来源57%是饮用水这其中还存在耗水不透明度的问题长此以往甚至会造成气候风险所以难怪AI数据中心会遭到抵制了同时也有企业做过海底数据中心如此一来不就解决了耗水的问题吗但是很遗憾这就涉及到了冷却系统里面面临的另外一个大挑战经济账的问题了

10:38

海底数据中心就是把服务器放置在壳体内并且沉到海水里因为海水的温度较低可以直接为壳体降温而且不需要额外补充机械能听上去是一个既节能又环保的方案对吧但是呢维利的专家就告诉我们这将对技术提出更高的要求

10:57

更高的技术要求就意味着企业需要在研发上投入更多但长期来看这确实是一个创新的解决方案

11:17

除了技术难题之外冷却系统的用电也一直居高不下有数据就显示冷却系统通常占数据中心平均电力消耗的40%不少巨头都在努力降低冷却系统的能源消耗但是搞不好反而会弄巧成种有论文研究就称

11:35

数据中心每将送风温度提高1摄氏度可以降低大约2.5%的震冷功率因此数据中心开始呈现把冷却系统温度从75华氏度提高到85华氏度的趋势连谷歌也采取了这样的做法但是这个做法还是挺危险的这相当于你设置的温度距离数据中心能够承受最高温度的缓冲区间是缩窄了反倒会导致系统性风险

12:00

比如说2021年新加坡的一家数据中心运营商为了节省冷却成本将温度提高到了危险的零件水平结果导致数据中心服务器大面积故障这种情况持续了将近一周真是得不偿失同时这篇论文也发出了警告数据中心受到热攻击的原因之一就是因为采用了激进的冷却策略也就是系统温度设置的太高减少了冗余度

12:26

所以如何让冷却系统更加节能成为了AI时代的挑战之一那维利技术的专家就告诉我们要降低冷却系统能耗主要分为三个大方向那现在从节能角度来讲其实可以分为三大方向一个是从风侧来做自然冷来做节能然后另外的话就是水侧自然冷还有就是浮侧自然冷

12:48

所谓的自然冷free cooling是指利用室外的低温冷源来给室内降温达到降低能耗的一种技术方法想象一下冬天我们闷在房间里非常热如果打开窗户让室外的冷空气进入房间就凉快了这就是自然冷而风策自然冷就是在窗户边放一些风扇向房间吹风加速室外冷空气的进入

13:11

水测自然冷和浮测自然冷则是将导体替换为了水和浮空测自然冷它是受地理条件限制比较大因为它是会把新风引到机房里来那这会儿的话就对空气质量之类有一定的要求就是即使做新风

13:26

也是会结合一些机械冷的那从我们来讲我们还是更专注于水侧自然冷和浮侧自然冷浮侧自然冷的话就是我们常规的风冷控调这个系统在温度相对来说比较低以及冬季的时候来通过浮泵工作来利用室外自然冷源那这会就不需要开压缩机了压缩机的功耗就是整个系统里边制冷功耗最大的部分那如果可以在一部分时间里边把压缩机替换成浮泵因为浮泵的功率是很低的那当然可以大大的节约冷耗

13:56

水侧自然冷做节能的话它就是通过室外的一些蒸发之类的把它的那个冷的能力间接的带到室内来风侧自然冷受到地理限制比较大水侧自然冷蒸发的水又太多所以目前既省电又省水的方案就是浮侧自然冷了浮侧自然冷它就是一个无水的制冷解决方案

14:17

那这个天然的它就不需要水它是靠浮泵靠冷媒来实现自然冷的不需要靠水的蒸发但是这种方式对技术就提出了很大的挑战需要长期的积累经验才能够控制好整套系统怎么才能更好的控制

14:33

然后让浮泵的工作时长更长一点点然后让浮泵和压缩机的切换能够更加的稳定更少的波动然后让它更节能它的难度是比做水车自然冷需要更难一点点的所以最大的难点就还是在于技术储备

14:50

除了节能环保之外如今数据中心还面临芯片升级的挑战我们之前视频中提到英伟达新出的Blackwell芯片由于功耗上升老旧的数据中心难以直接部署甚至一些公司由于业务转型需要将以CPU为主的计算设备升级到以GPU为主如何改造就成为了当下的难题

15:14

在AI来之前数据中心的分类其实都是以风冷为主的那它的单机位公寓度才5到10千瓦而且其实10千瓦的都不是很多了主要是5到6千瓦这样的为主那现在我要升级计算首先要把风冷设备的散热量加够然后再去额外的再去补充液冷部分

15:34

既然冷却系统可以升级为什么还有一些企业会选择花很多资金重建数据中心呢这就不得不说到旧机房升级的瓶颈了那对于制冷它主要就是空间的问题一般情况下从我们当前的设计经验来看制冷设备的空间往往可能是够的因为原先的单机柜6000瓦那现在单机柜40千瓦那单机柜的功率密度提升了6倍还多

16:00

原先一个六个机柜解决的问题现在只需要一个机柜行业里面有一个说法就是数据中心的尽头其实是电力所以咱们在扩容的时候往往首先要考虑的还是电力的问题那为什么电力是制约数据中心升级的因素AI爆发又给供电系统带来了哪些挑战呢接下来我们就来聊聊供电系统

16:26

那我们在AI电力战的那一期视频当中讲过AI数据中心带来了大量的电能消耗未来将给电网也会带来供应缺口其实不只是外部的电网AI数据中心内部的供电也面临着巨大的压力其中很大的因素就是在于占地面积因为整个的功率密度提升供配电和IT机房的占比出现了很大的偏差占地面积成为了一个很大的挑战

16:52

正因为这些难点成为了老旧数据中心升级困难的原因其中最为棘手的就是占地问题了在解析这个问题之前为了便于大家理解我们先简单的介绍一下供电系统的结构供电系统的结构主要分为四个层级试电或者发电机将电能输送到变配电系统

17:13

变配电系统会给冷却系统与不间断电源Uninterruptible Power Supply,简称UPS供电UPS再将电能送到主机房的电源分配单元Power Distribution Unit,简称PDU由PDU给每个机柜分配电能

17:30

其中发电机是为了在试电发生故障的时候有应急的电力输入但是发电机启动需要一定的时间而UPS就包含了大容量电池能够保证服务器继续运行5到15分钟为发电机启动争取时间当然供电系统还会根据试电线路数和冗余结构的不同分为DRR架构、RRR架构还有RN架构等等这里我们就不多赘述了

17:55

回到占地面积的问题由于服务器功耗增加之后需要额外的供电设备但是供电设备实在是太占地了从传统的数据中心建设来看它会有传统的中压室、低压室、电力室还有一些它的电池室等等

18:11

这些传统的产品都会通过线来做连接这些物理连接由于它是分散于各个厂家的产品它的标准的制式标准的体积都不是很柔和另外一个他们的整个的部署的物理距离中间的一般都是都会有一些间隙

18:28

所以有限的空间成为了制约老旧数据中心升级的痛点想发展AI重建数据中心成为了更好的选择但是数据中心的设计寿命有20到30年GPU换代一般是3到5年总不能隔几年重建一次这次行业发展出了新的方向那就是设备一体化

18:49

我们针对整个的占地面积我们推出了交流直流供应电一体化的电力模组就像我们传统的组装式的电脑现在变成了一体机身一样的我们通过将UPS供应电被压器补偿废电柜多个产品融合为一起提供了一个工程产品化的一个产品这样可以将我们占地面积减少至少30%当然我们还有一个新型的解决方案采用我们的供应电电力模组采用背靠背的这种方式通过上出风

19:18

这样的话我们可以把传统的电力系统的面积再缩小50%缩小其他设备的占地面积不光有利于老旧数据中心的升级那么新的数据中心也能够带来更高的经济效益因为腾出来的空间就可以多摆点计算用的机柜多一些算力能够缩短模型的训练和推理时间除了缩小设备占地之外供电系统的另外一个趋势是提升电能传输效率众所周知每个设备都有电阻

19:47

电能在一层层设备的转换中总会伴随着能量损失如此一来为了满足服务器机柜的电能需求前端的共配电设备需要留有更多的冗余占据更大的面积而提升传输效率之后不仅能够减少设备的数量还能够降低数据中心的能耗达到节能减排的效果那该从哪些方面来提升效率呢

20:10

UPS我们采用了通化硅的一个产品线这样整个的效率提升了很多第二个采用了很多现在我们叫SCB的多晶合金的变压器第三个通过以传统的线缆方式改用铜牌的方式来连接进一步降低了线路的损耗来提升整体的效率通过我们对末端配电的服务器的快速提升我们推出了有1000安培的小母线来解决我们末端负载未来可以扩容100千瓦150千瓦的这样一个服务器的未来弹性扩容的一个需求

20:39

那最后我们来聊聊顾华提到的第四个挑战快速部署有意思的是行业为此竟然呈现出了预支化的趋势这能行得通吗

20:53

如今全球的AI大战正打得火热急剧增长的算力需求促使着各大公司新建AI数据中心这就对整个行业提出了建设速度的要求毕竟AI数据中心早一天上线就能够带来更多的经济效益大家也在纷纷尝试创新的解决方案比如说木质数据中心用木材作为关键结构部件来建设数据中心

21:17

那难道他们就不怕遇到地震台风或者火灾啥的把整个数据中心都弄没了吗其实尽管募制数据中心听上去是一个非常激进的概念但是早在2019年就有公司建成并且投入使用了

21:32

而他们使用的也并不是那种直接从树上锯下来的木板,而是名为正交交合木,Cross-Liminated Timber,简称CLT的建筑材料。这种材料具有极高的强度和均匀性,直接作为承重墙板或者楼板使用都没问题。同时它还有耐火的特性,英国就有栋名为Stathos的九层楼公寓采用了这种CLT材料建成。

21:56

木质材料不仅能满足环保的要求还能通过预质化将整体的建设速度加快40%到80%当然数据中心的建设不光是外部的建筑它还有内部的基础设施需要定制而现在冷却系统与供电设备也走向预质化的道路

22:17

现在目前的计算中心呢客户的需要可能是在六个月之内就要建设好这个计算中心也是这个传统的这个建造方式所能够达成的时间维迪的360 AI 计算解决方案呢

22:32

可以协助客户缩小50%左右的时间我们还在海外和一些算力公司互联网公司根据它算力的需要全套的定制了预制化的基础设施就是说我们依据它算力的需要和模型我们优先把数据中心的基础设施给配套好同时对里面的供电智能软件甚至工程的材料的预制化都进行了详细的部署

23:00

将设备由定制改为预制就能够大幅度的节省工程的时间但是这其中又会存在着匹配性的问题不同的客户呢他确实有很大的需求上的差别比如说政府和金融项目金融客户他最在乎的就是这个高可靠性他对创新呢持稳坚的态度对绿色呢他也持稳坚的态度但是对互联网公司来说他在乎的是创新性成本部署速度

23:31

所以说在这两种客户之间我们提供的是差异化的方案和服务不同的数据中心都有自己独特的需求如果失去了定制的环节是否就意味着预制化的设备难以大量的铺开呢专家就给我们解释到所谓的预制化其实是预制了各个部件的模块在一个统一的平台下可以将这些模块按需求来组装这样就能满足不同的客户了

23:58

VD实际上它在长期的发展和实践里面它形成了很多标准化的组件那么所以说在新的需求来临的时候我们肯定优先去选择在这个积木库里面去提取一些适合我们新的场景的一些部件和组件这样的话就可以高效率地搭建出一个适应客户心得需要的这样一个产品类型

24:24

打个比方就像我们买来的乐高积木其实也都是很多通用的小块它既可以拼成汽车也能拼成飞机虽然我们常说AI的飞跃源自于芯片的积累然而为芯片运行打下基石的是基础设施的技术进步它们如同无形的兵部尚书在幕后默默的支持和调控着前线士兵的作战行动让AI大模型训练顺利的推进

24:52

就像我们视频中提到的士兵的作战效率在提升那么兵部射出的水平也要相对的提高这对整个AI芯片的上下优势上都提出了更高的要求是挑战也是机遇随着更高能力、更多参数以及更大AI模型的投入训练也许我们会看到数据中心更快的升级迭代有更多的创新技术来支持AI大模型的技术大战也再次的感谢维地技术对我们视频的支持

25:20

好以上就是我们这期视频的全部内容了你们的留言点赞和转发是支持我们硅谷101做好深度科技和商业内容的最佳动力那我们就下期节目再见了bye

评论区