字数 1975,阅读大约需 10 分钟

LLM:token是什么?一文入门上下文窗口!

在日常使用AI的过程中,经常会出现一个问题:什么是tokens,为什么会有tokens限制,在开发agent的过程中,为什么要关注上下文的质量、容量和流程。这一切都和LLM的tokens紧密相关,理解tokens,就是入门LLM的重要步骤,对后续的开发和日常使用都会提升很多。高价值的tokens和流程编排,决定了在同样模型上的输出质量更高。

token是什么

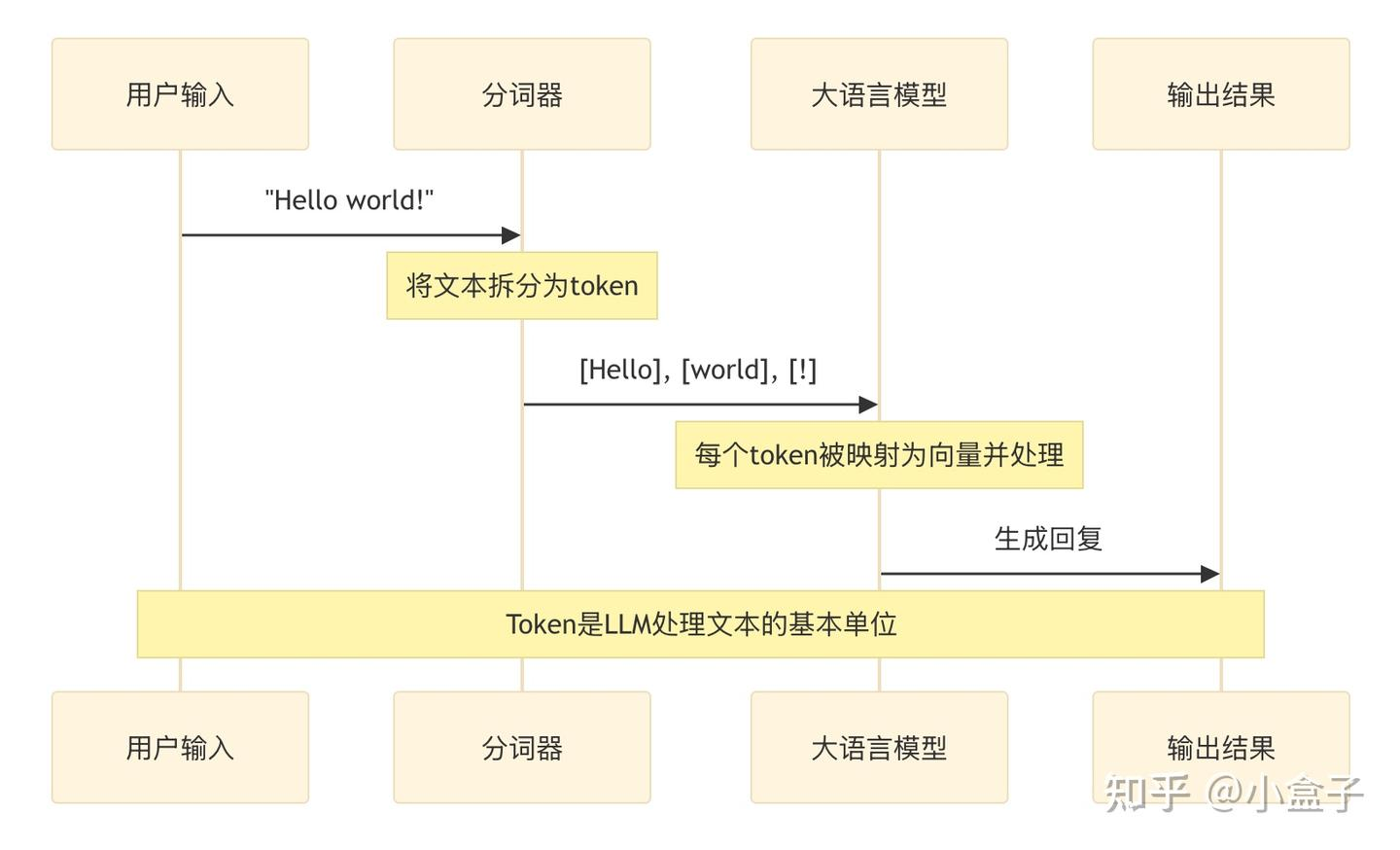

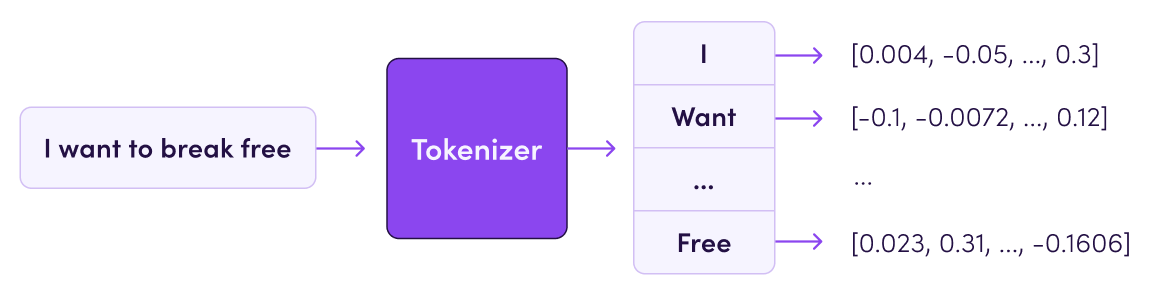

定义:Token 是模型处理文本的基本单位,可以是单个单词、单词的一部分(例如子词)、字符或标点符号。

作用:Token 是将自然语言转换为模型可理解的数字表示的桥梁,帮助模型捕捉语言的结构和语义信息

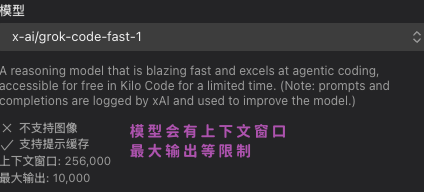

最大tokens:最大标记是指模型在一次推理或输出中能够处理(输入和输出的总和)的最大Token数量

大型语言模型(LLM)不能真正理解原始文本,相反,文本被转换为称为token的数字表示形式,然后将这些token提供给模型进行处理。token代表模型可以理解和生成的最小意义单位,是模型的基础单元。根据所使用的特定标记化方案,token可以表示单词、单词的一部分,甚至只表示字符。token被赋予数值或标识符,并按序列或向量排列,并被输入或从模型中输出,是模型的语言构件。直观理解:

1 token ~= 4 chars in English

1 token ~= ¾ words

100 tokens ~= 75 words

1-2 句子 ~= 30 tokens

1 段落 ~= 100 tokens

1,500 单词 ~= 2048 tokens

将文本划分为不同token的正式过程称为 tokenization。tokenization捕获文本的含义和语法结构,从而需要将文本分割成重要的组成部分。

tokenization是将输入和输出文本分割成更小的单元,由 LLM AI 模型处理的过程。tokenization可以帮助模型处理不同的语言、词汇表和格式,并降低计算和内存成本,还可以通过影响token的意义和语境来影响所生成文本的质量和多样性。根据文本的复杂性和可变性,可以使用不同的方法进行tokenization。大模型基础组件 - Tokenizer - 知乎[1]

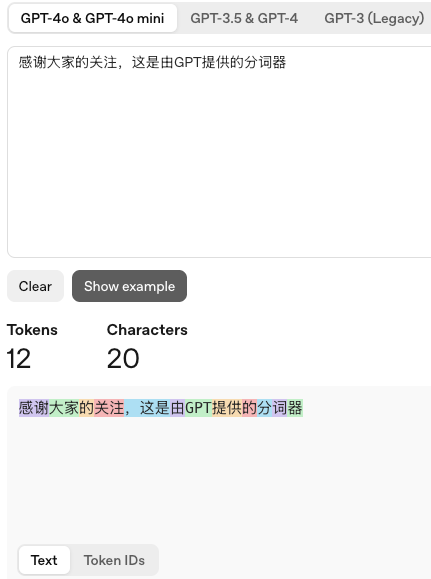

可以在GPT大模型提供的tokenized里感受tokenizer:Tokenizer - OpenAI API[2]

最大tokens

指模型在一次推理中能够考虑的最大Token数量,包含输入和输出的总和。

为什么要在AI问答的过程中关注上下文窗口的数据内容质量,原因是LLM的最大tokens是有限制的:

為什麼模型輸出的 token 通常都限制在 4000 個左右,但輸入現在卻增加到 100 萬個? : r/LocalLLaMA[3]

Transformer 模型中增加一个 Token 对计算量的影响_transformer token-CSDN博客[4]

这个问题源于 LLM 注意力机制的工作方式,以及它们所训练的数据类型。注意力机制使用 K、V 和 Q 值的点积,将每个 token 与其他每个 token 进行比较。在技术上,transformer的限制,决定了计算量的复杂性。

1. 位置编码的范围:Transformer 模型通过位置编码(如 RoPE、ALiBi)为每个 token 分配位置信息,其设计范围直接限制模型能处理的最大序列长度。

2. 自注意力机制的计算方式:生成每个新 token 时,模型需计算其与所有历史 token(输入+已生成输出) 的注意力权重,因此总序列长度严格受限。KV Cache 的显存占用与总序列长度成正比,超过窗口会导致显存溢出或计算错误。增加一个 Token 会导致自注意力机制的计算量增加 O(N^2)。这些增加会使得模型的计算复杂度和存储需求增加

上下文窗口

大型语言模型 (LLM) 的上下文窗口(或“上下文长度”)是模型在任何时候可以考虑或“记住”的文本量,以词元为单位。更大的上下文窗口使 AI 模型能够处理更长的输入,并将更多的信息整合到每个输出中。

因为Attention的计算量和内存需求都随着序列长度增加而成平方增长,所以增加序列长度很难。因此,在工程实践中,我们要200%关注上下文质量和流程管理编排。

用AI领域大佬的话:LLM就是在做成语接龙游戏,在工程实践中,大家可以考虑下怎么更好的玩LLM游戏。

缺陷:增加 LLM 的上下文窗口大小意味着更高的准确性、更少幻觉、更连贯的模型响应、更长的对话以及分析更长数据序列的能力提高。然而,增加上下文长度并非没有代价:它通常需要增加算力要求,导致成本增加,并且更容易受到对抗性攻击的影响

上下文示例

在很多工程领域,上下文可以更好的成为agent高效工作的必要内容:

1. 聊天机器人和虚拟助理:现代聊天机器人使用上下文窗口来保存对话历史。这使它们能够理解后续问题、回溯之前的内容,并提供更自然、更连贯的互动,避免重复或不相关的回复。谷歌的双子座(Gemini)等模式利用大型上下文窗口进行复杂的对话。

2. 用于金融预测的时间序列分析: 金融模型分析过去股票价格、经济指标或交易量在定义的上下文窗口中的序列,以预测未来的市场走势。金融领域中的 AI 通常依赖于经过精心调整的上下文窗口。

3. 预测文本算法(Predictive Text Algorithms):当您在智能手机上打字时,键盘会根据其上下文窗口中的前导词建议下一个单词,从而提高打字速度和准确性。此功能是小型高效上下文窗口的直接应用。

上下文工程

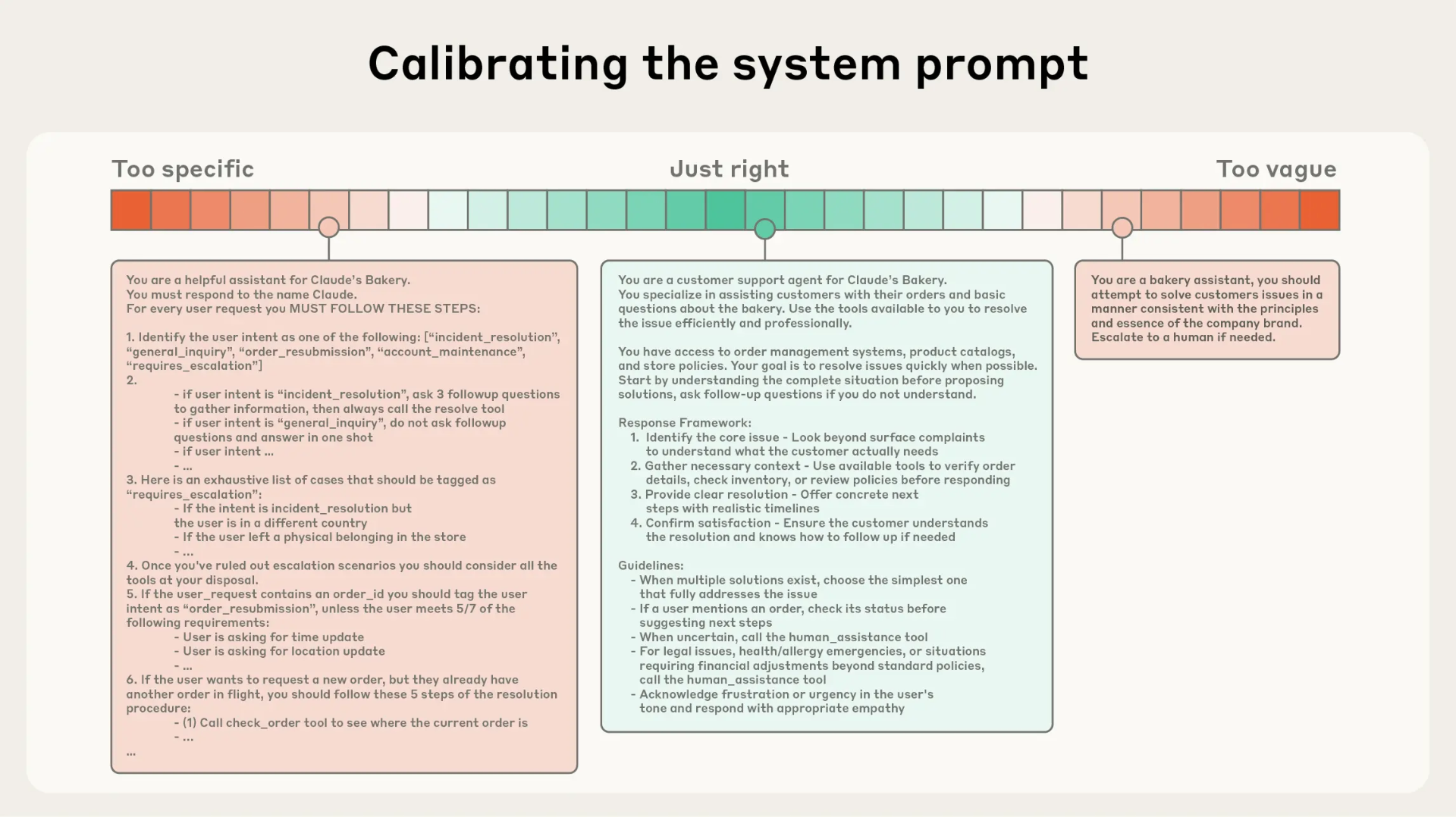

Anthropic官方新发布智能体文章:Effective context engineering for AI agents,现在分享给大家。解决的问题是:如何在 LLM 固有的限制条件下,最大化这些 token 的效用,从而持续获得理想的结果。要有效地驾驭 LLM。

为了最好的利用大模型LLM,上下文工程是有必要且复杂精心设计的。后面会单独将Anthropic的上下文实践博客给大家讲解,很有价值。

彩蛋结尾

嘿,别滑了!手指停一停,听我说句悄悄话👇

🌟 关注我:下次更新,系统会自动弹窗提醒你,就像外卖到了那样准时!再也不怕错过我的脑洞和干货啦~

📌 收藏本文:这篇宝藏文章,现在不码住,以后想找只能捶胸顿足!点个收藏,让它成为你的私人知识库,随时回来挖宝~

❤️ 点赞在看:如果逗笑你了或者对你有用,麻烦高抬贵手点个赞!你的每个赞都是我熬夜写文的“鸡血”,让我更有动力产出更多有趣内容~

(据说一键三连的人,明天会多捡到10块钱!)

引用链接

[1] 大模型基础组件 - Tokenizer - 知乎: https://zhuanlan.zhihu.com/p/651430181[2] Tokenizer - OpenAI API: https://platform.openai.com/tokenizer[3] 為什麼模型輸出的 token 通常都限制在 4000 個左右,但輸入現在卻增加到 100 萬個? : r/LocalLLaMA: https://www.reddit.com/r/LocalLLaMA/comments/1dns6j8/why_are_model_output_tokens_mostly_limited_to/?tl=zh-hant[4] Transformer 模型中增加一个 Token 对计算量的影响_transformer token-CSDN博客: https://blog.csdn.net/weixin_43883917/article/details/137059211

评论区